Ewolucja procesorów: od Pentium do najnowszych Intel Core

Początki dominacji: Era procesorów Pentium

Era procesorów Pentium zapoczątkowała nowy rozdział w historii rozwoju technologii komputerowej, stanowiąc fundament późniejszej dominacji Intela na rynku jednostek centralnych. Procesory z rodziny Pentium zostały zaprezentowane w 1993 roku jako następcy udanej serii 80486. Był to przełomowy moment nie tylko ze względu na wzrost wydajności, ale również dzięki zupełnie nowej nazwie marki, która stała się synonimem mocy obliczeniowej lat 90. XX wieku. Kluczowym aspektem, który pozwolił Pentium zdobyć pozycję dominującą, była obecność dwóch potoków wykonawczych (technologia superskalarna), co umożliwiało jednoczesne wykonywanie dwóch instrukcji. Dzięki temu architektura ta skutecznie wykorzystywała zasoby CPU, wyraźnie wyprzedzając konkurencyjne rozwiązania w zakresie wydajności na takt zegara.

W kolejnych latach Intel rozwijał rodzinę Pentium, wypuszczając na rynek takie modele, jak Pentium Pro, Pentium II, Pentium III i Pentium 4. Każda z tych wersji wprowadzała istotne usprawnienia technologiczne – od wsparcia dla zestawów instrukcji MMX, po wdrożenie technologii Hyper-Threading i wyższych częstotliwości taktowania. W latach 90. i na początku XXI wieku procesory Pentium były głównym wyborem zarówno dla użytkowników domowych, jak i profesjonalistów. Pod względem marketingowym Intel zastosował agresywną strategię, m.in. inwestując w kampanie reklamowe i program „Intel Inside”, co dodatkowo wzmocniło obecność marki Pentium na rynku komputerów osobistych. Początki dominacji Intela w erze Pentium nie tylko wyznaczyły nowe standardy wydajności, ale również przygotowały grunt pod późniejsze generacje procesorów Intel Core, z którymi integrują wiele technologicznych fundamentów zapoczątkowanych właśnie w epoce Pentium.

Rewolucja architektury: Przesiadka na Intel Core

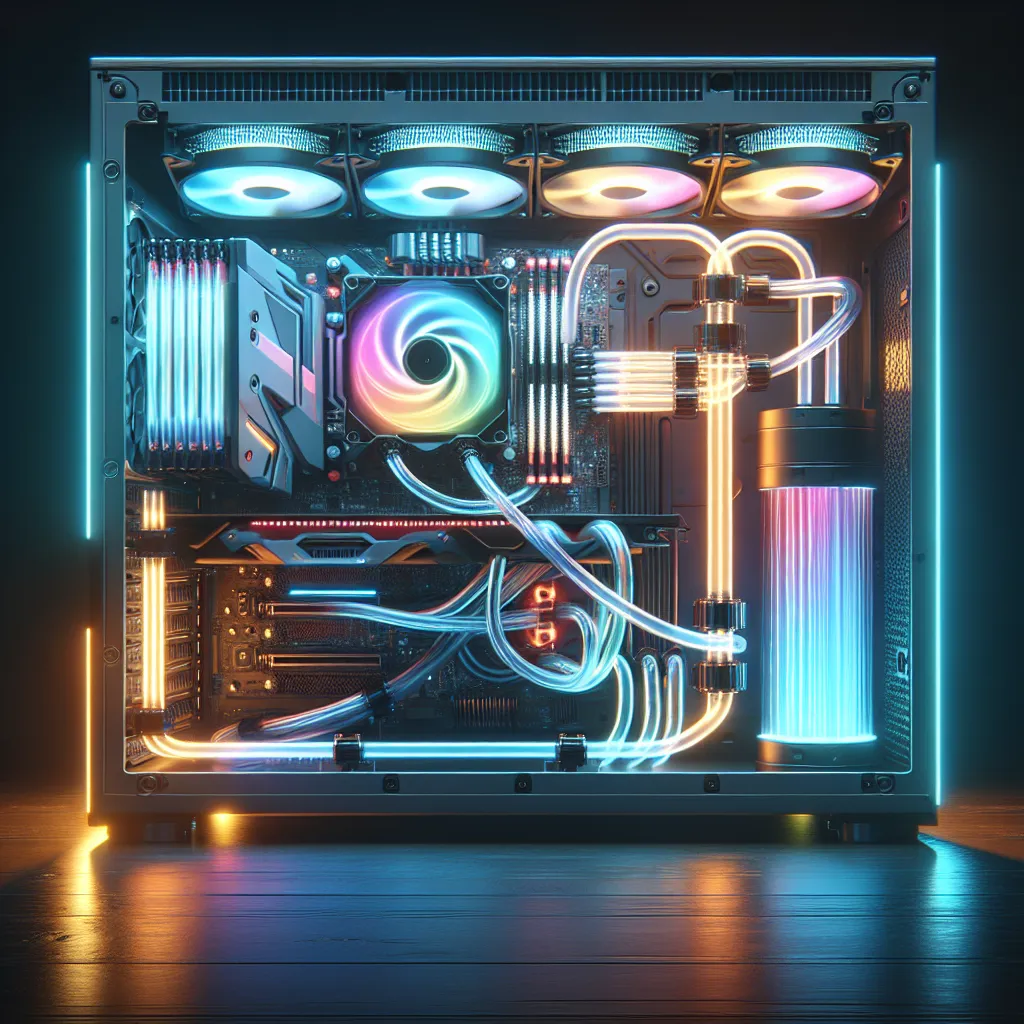

Rewolucja architektury, jaką była przesiadka z procesorów Intel Pentium na rodzinę Intel Core, stanowi jedno z najważniejszych wydarzeń w historii rozwoju procesorów. Wprowadzenie architektury Intel Core w 2006 roku oznaczało fundamentalną zmianę w podejściu do projektowania jednostek centralnych. Podczas gdy Pentium, zwłaszcza w swoich późniejszych wersjach jak Pentium 4, kładło nacisk na zwiększanie częstotliwości taktowania, nowa linia Intel Core przyniosła zupełnie inną filozofię – większą efektywność energetyczną i wielordzeniowość.

Debiutujące z architekturą Intel Core procesory, takie jak Core Duo i Core 2 Duo, zawierały dwa rdzenie fizyczne w jednej strukturze, co pozwoliło na znacznie lepsze zarządzanie wielozadaniowością i obniżenie zużycia energii. Był to zdecydowany krok naprzód względem Pentium 4, który osiągał coraz wyższe temperatury i miał ograniczenia w skalowalności architektonicznej. Architektura Core była bardziej zoptymalizowana, bardziej wydajna na wat i otworzyła drogę dla kolejnych technologicznych innowacji, takich jak Intel Turbo Boost czy Hyper-Threading w bardziej zaawansowanej formie.

Kluczowe słowa, takie jak „Intel Core”, „architektura procesorów Intel”, „przesiadka z Pentium”, a także „rewolucja architektury CPU” doskonale obrazują, jak istotna była ta transformacja. Dzięki przejściu na Intel Core, komputery osobiste i laptopy zyskały na wydajności, przy jednoczesnym zmniejszeniu zapotrzebowania na energię – co było wyjątkowo istotne zwłaszcza w czasach rosnącej popularności urządzeń mobilnych.

Wydajność i energooszczędność: Nowe standardy w procesorach

Wraz z dynamicznym rozwojem technologii komputerowej, kwestia wydajności procesorów oraz ich energooszczędności stała się kluczowym wyznacznikiem postępu w tej dziedzinie. Porównując pierwsze generacje układów z serii Intel Pentium do najnowszych modeli z rodziny Intel Core, można zauważyć olbrzymi przeskok zarówno pod względem mocy obliczeniowej, jak i zminimalizowanego zużycia energii. Starsze procesory Pentium, produkowane w technologii 250 nm i większych, charakteryzowały się wysokim poborem mocy oraz generowaniem dużych ilości ciepła, co wymagało stosowania rozbudowanych systemów chłodzenia.

Wprowadzenie serii Intel Core, począwszy od pierwszej generacji, zapoczątkowało prawdziwą rewolucję w zakresie efektywności energetycznej procesorów. Współczesne jednostki, jak Intel Core 13. i 14. generacji, oparte na zaawansowanych architekturach (takich jak Raptor Lake czy Meteor Lake), produkowane są w procesie technologicznym 10 nm (Intel 7), a w niedalekiej przyszłości również w procesie 7 nm (Intel 4). Przekłada się to na wyraźnie niższy pobór mocy przy jednoczesnym zwiększeniu wydajności. Dzięki zastosowaniu technologii takich jak Intel Thread Director oraz hybrydowa architektura (połączenie wydajnych rdzeni P-cores i energooszczędnych rdzeni E-cores), możliwe jest dynamiczne zarządzanie zużyciem energii w zależności od aktualnego obciążenia systemu.

Wydajność współczesnych procesorów Intel nie ogranicza się już tylko do wzrostu częstotliwości taktowania. Nowoczesne jednostki obsługują wiele wątków jednocześnie, zapewniają wsparcie dla zaawansowanych instrukcji SIMD, a także wykorzystują sztuczną inteligencję i uczenie maszynowe do optymalizacji działania aplikacji. Równocześnie coraz większą rolę odgrywają funkcje związane z redukcją zużycia prądu – od zaawansowanego zarządzania stanami energetycznymi (takimi jak C-States i P-States), po inteligentne planowanie zadań przez system operacyjny we współpracy z procesorem.

Podsumowując, zmiany jakie zaszły w procesorach od ery Pentium do najnowszych modeli Intel Core, to nie tylko wzrost wydajności, ale przede wszystkim ustanowienie nowych standardów w zakresie energooszczędności procesorów. Dzięki tym osiągnięciom, komputery osobiste, laptopy czy serwery oferują dziś nie tylko niespotykaną wcześniej moc obliczeniową, lecz także znacznie mniejsze zapotrzebowanie na energię, co ma kluczowe znaczenie zarówno dla użytkowników mobilnych, jak i dla ekologii oraz zrównoważonego rozwoju.

Przyszłość obliczeń: Sztuczna inteligencja i komputery kwantowe

Przyszłość obliczeń to dynamicznie rozwijający się obszar, w którym kluczową rolę odgrywają dwie przełomowe technologie: sztuczna inteligencja i komputery kwantowe. W kontekście ewolucji procesorów – od klasycznych układów Pentium po zaawansowane jednostki Intel Core – widzimy wyraźne przesunięcie w stronę rozwiązań zoptymalizowanych pod kątem zadań AI oraz obliczeń równoległych. Nowoczesne procesory, takie jak Intel Core i9 z serii Meteor Lake, zostały wyposażone w dedykowane jednostki do przetwarzania zadań związanych ze sztuczną inteligencją (tzw. AI accelerators), co znacząco zwiększa ich wydajność w aplikacjach uczenia maszynowego, rozpoznawaniu obrazów czy przetwarzaniu języka naturalnego.

Sztuczna inteligencja staje się obecnie jednym z głównych motorów napędzających rozwój sprzętu komputerowego. Wraz z rosnącą popularnością AI, producenci procesorów, tacy jak Intel, AMD czy NVIDIA, inwestują w rozwiązania hybrydowe, które łączą klasyczne jednostki CPU z układami GPU oraz NPU (Neural Processing Unit). Dzięki temu możliwe jest wykonywanie złożonych algorytmów AI w czasie rzeczywistym, co otwiera drzwi do innowacji w takich dziedzinach jak pojazdy autonomiczne, medycyna diagnostyczna czy systemy rekomendacji.

Równocześnie, na horyzoncie pojawia się zupełnie nowy paradygmat – komputery kwantowe. Choć obecnie znajdują się one w fazie eksperymentalnej, ich potencjał w zakresie rozwiązywania problemów niemożliwych do obsłużenia przez tradycyjne procesory jest ogromny. Intel intensywnie pracuje nad technologią qubitów krzemowych, dążąc do stworzenia skalowalnych i bardziej stabilnych jednostek kwantowych. Wykorzystanie komputerów kwantowych może zrewolucjonizować między innymi kryptografię, symulacje molekularne oraz optymalizację zadań logistycznych i finansowych.

Z punktu widzenia przyszłości obliczeń, sztuczna inteligencja i komputery kwantowe nie są konkurencyjnymi technologiami, ale raczej wzajemnie się uzupełniającymi narzędziami. W miarę jak możliwości klasycznych procesorów zbliżają się do granic fizycznych, rozwój inteligentnych jednostek obliczeniowych i kwantowych systemów zwiastuje nową erę, w której wydajność, elastyczność i zdolność do przetwarzania ogromnych ilości danych będą miały kluczowe znaczenie dla postępu technologicznego.